مدل هوش مصنوعی GPT-4 نقصهای امنیتی را با نرخ موفقیت 53 درصدی شناسایی کرد

منبع: https://rasanika.com

منبع: https://rasanika.com

محققان توانستند با موفقیت بیش از نیمی از وبسایتهای آزمایشی خود را با استفاده از باتهای GPT-4 هک کنند. این مدل ابداعی محققان میتواند باتهای جدیدی برای انجام وظایف خاص تولید کند. بهطورکلی، نتایج این پژوهش میتواند برای جلوگیری از سوءاستفاده از مدلهای هوش مصنوعی در هکهای روز صفر مفید باشد.

محققان دانشگاه ایلینوی اربانا-شمپین توانستند از روشی به نام «برنامهریزی سلسلهمراتبی با عاملهای وظیفهمحور» یا «HPTSA» برای تولید خودکار چندین بات از مدل زبانی بزرگی استفاده کنند؛ در این روش GPT-4 میتواند باتهای دیگری بسازد و بهاینترتیب از آسیبپذیریهای روز صفر و ناشناخته برای هککردن استفاده کند.

چند ماه پیش، همین محققان توانستند از GPT-4 برای هک خودکار آسیبپذیریهای روز اول یا N-day (نقصهای امنیتی که شناخته شده اما هنوز اصلاح نشدهاند) بهره ببرند. به گفته محققان، اگر لیست آسیبپذیریهای شناختهشده به GPT-4 داده شود، این هوش مصنوعی میتواند بهتنهایی از 87 درصد این آسیبپذیریها برای هک استفاده کند.

استفاده از هوش مصنوعی GPT-4 برای شناسایی نقصهای امنیتی

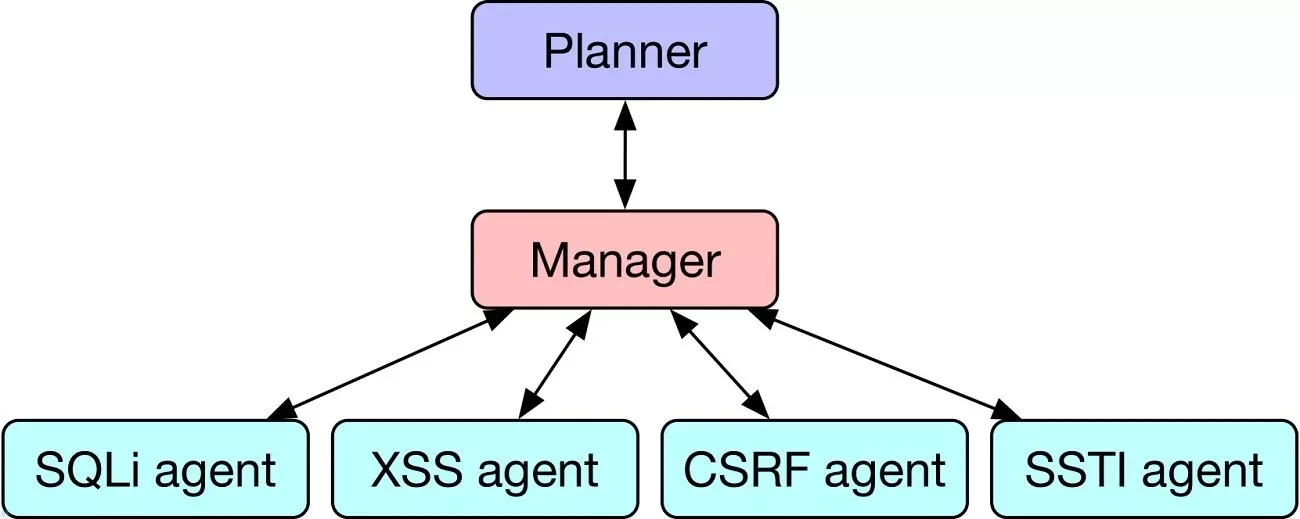

محققان در پژوهش جدیدشان، با روش HPTSA بهجای اختصاصدادن مدل هوش مصنوعی برای حل بسیاری از مسائل پیچیده، از «عامل برنامهریزی» (Planning agent) استفاده کردهاند که مانند مدیر بر کل فرایند نظارت میکند و خودش چندین زیرمجموعه Subagent میسازد که هرکدام مخصوص کاری هستند. فرایند این کار بسیار شبیه سازمانی با یک رئیس و چند کارمند است که در آن عامل برنامهریزی با عوامل دیگر مسائل مختلف را بررسی و برطرف میکند.

هنگامی که مدلهای هوش مصنوعی با روش HPTSA در برابر 15 آسیبپذیری در وب قرار گرفتند، توانستند 550 درصد کارآمدتر از مدلی معمولی عمل کنند. بهعبارت دقیقتر، آنها توانستند 8 آسیبپذیری از 15 آسیبپذیری روز صفر را هک کنند (یعنی با نرخ موفقیت تقریبی 53 درصدی). در مقابل مدلی انفرادی توانست فقط در هک 3 مورد از 15 آسیبپذیری موفق باشد.

از سویی این نگرانی وجود دارد که این مدلها به برخی کاربران اجازه دهند بهصورت مخرب به وبسایتها و پلتفرمها حمله کنند. اما محققان این پژوهش میگویند چتبات GPT-4 بهتنهایی نمیتواند چیزی را هک کند.